主流大语言模型的技术原理细节

作者:spring

1.比较 LLaMA、ChatGLM、Falcon 等大语言模型的细节:tokenizer、位置编码、Layer Normalization、激活函数等。2. 大语言模型的分布式训练技术:数据并行、张量模型并行、流水线并行、3D 并行、零冗余优化器 ZeRO、CPU 卸载技术 ZeRo-offload、混合精度训练、激活重计算技术、Flash Attention、Paged Attention。3. 大语言模型的参数高效微调技术:prompt tuning、prefix tuning、adapter、LLaMA-adapter、 LoRA。

0. 大纲

1. 大语言模型的细节

1.0 transformer 与 LLM

1.1 模型结构

1.2 训练目标

1.3 tokenizer

1.4 位置编码

1.5 层归一化

1.6 激活函数

1.7 Multi-query Attention 与 Grouped-query Attention

1.8 并行 transformer block

1.9 总结-训练稳定性

2. LLM 的分布式预训练

2.0 点对点通信与集体通信

2.1 数据并行

2.2 张量并行

2.3 流水线并行

2.4 3D 并行

2.5 混合精度训练

2.6 激活重计算

2.7 ZeRO,零冗余优化器

2.8 CPU-offload,ZeRO-offload

2.9 Flash Attention

2.10 vLLM: Paged Attention

3. LLM 的参数高效微调

3.0 为什么进行参数高效微调?

3.1 prompt tuning

3.2 prefix tuning

3.3 adapter

3.4 LLaMA adapter

3.5 LoRA

3.6 实验比较

4. 参考文献

标签:

Paged

Flash

ZeRO

3D

adapter

语言

模型

tuning

CPU

offload

LLaMA

prefix

Attention

prompt

query

transformer

免责声明:凡本网站发布的文章、图片、音频、视频等内容所表述的观点和立场不代表本网站的观点和立场,若对该观点或立场有疑义或异议,请及时用电子邮件或电话通知我们,以迅速采取适当措施,避免给双方造成不必要的经济损失。凡本网站发布的所有文章 、图片、音频、视频文件等资料的版权归版权所有人所有,本站采用的非本站原创文章及图片等内容无法一一和版权者联系,如果本网所选内容的文章作者及编辑认为其作品不宜上网供大家浏览,或不应无偿使用,请及时用电子邮件或电话通知我们,以迅速采取适当措施,避免给双方造成不必要的经济损失。

相关阅读

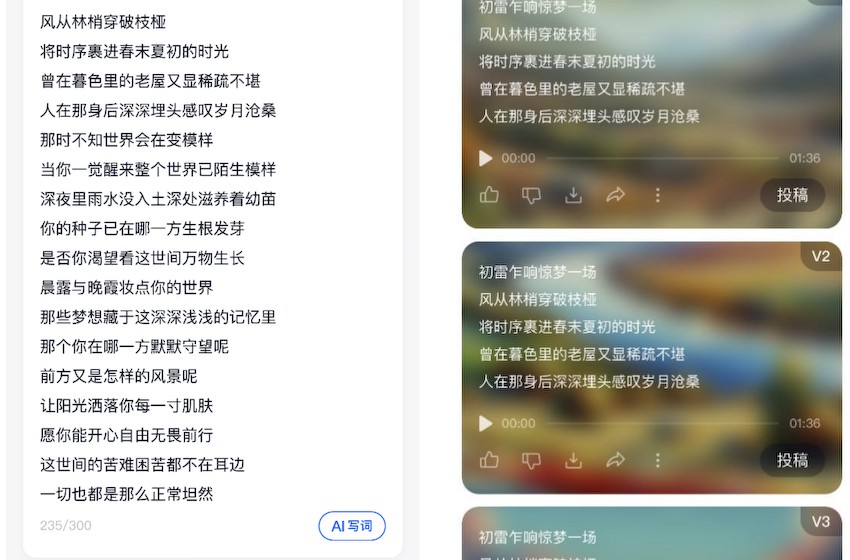

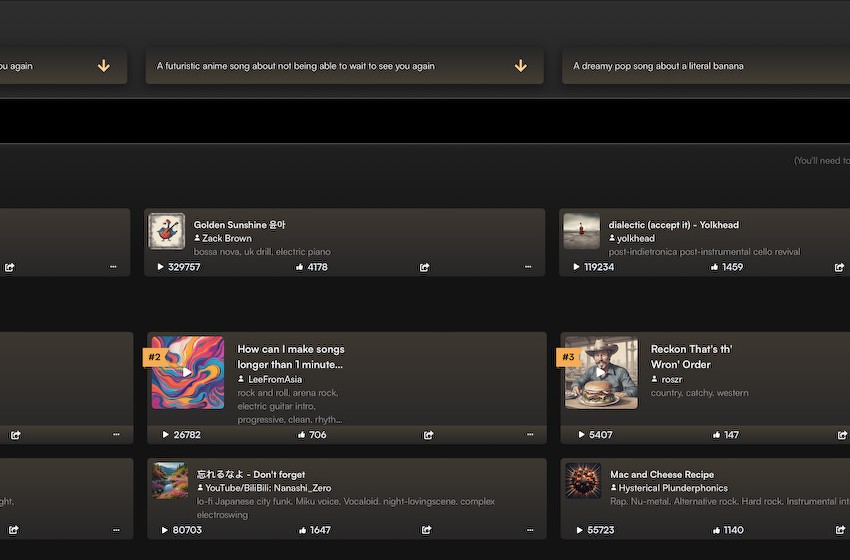

以假乱真,天工音乐大模型带来颠覆式AI体验

2024.04.03

《Umbra Fields》steam页面上线 3D迷宫RPG

2023.10.19

宝格丽75 周年展览,珠宝世界的永恒传奇

2023.10.19

两大巨头宣布大动作,携手开发RISC-V芯片!A股布局公司名单出炉,两路资金出手这些股

2023.10.19

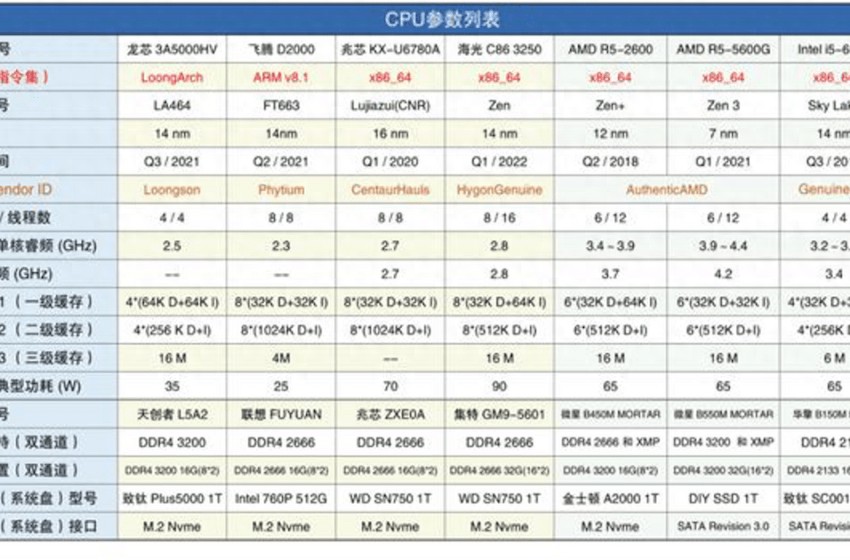

国产芯片vs“国际水平”,有距离也有超越!

2023.10.19